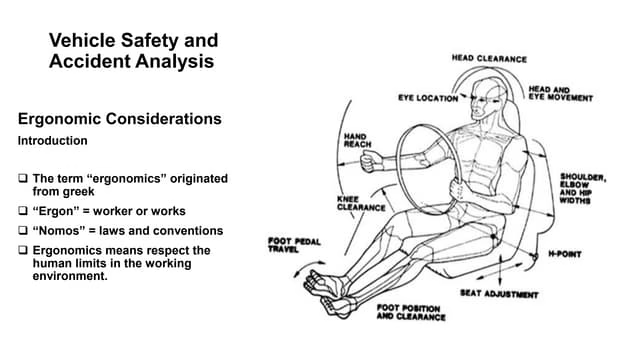

眼动识别听起来是一个非常高端的功能,往往用于一些科学研究项目,比如研究驾驶员在行驶过程中关注的座舱热点区域,从而得出合理的人机布置,让按键、信息出现在合理的地方,而不是:

实际上在消费电子领域,眼动功能也已经有在应用,比如充满未来设计风格的Apple Vision Pro里面搭载了眼动追踪和隔空手势操作功能,实现更好的VR、MR交互。

再比如PS VR2,会根据用户的视角焦点实时调整重点细节渲染区域,这种动态动态追踪方式来提升渲染的效率,有效平衡硬件资源和体验效果。

而在智能座舱应用,也有通过视线追踪功能提升驾驶安全性的应用,比如宝马XM等配备智能驾驶辅助功能的车型通过红外摄像头对驾驶员视线进行检测,确保驾驶员有在关注行驶道路的状况。

但是这种应用离我们想要的眼动识别功能还有很大的距离,相信大家想要的是“看哪打哪”的效果,这就对视线追踪系统分辨视线位置的解析度有很高的要求了。

驾驶视线可能只需要判断前方、左右两侧的的视线合集就可以了,系统算法所需要反馈的只有大的方向:

闭眼/看前方/看左/看右/其他状态

这几种状态的视线合集相对较大。

而要实现“看哪打哪”,则需要对用户眼前所有的画面进行较小颗粒度的识别,视线合集需要进一步缩小,实现更精准的区域定位。可以想象把屏幕、HUD等用户界面内容进行网格化的划分,系统算法所需要反馈的会是类似坐标的内容:

(-5,2)左上

(0,0)正中间

(3,2)右下

听起来好像不是那么困难,但实际用户在车里面的坐姿的变化范围远比VR眼镜里面需要判断眼睛到屏幕的距离复杂,不同驾驶员的身高、座椅的前后以及开车过程中身体姿势的变化都让程序员频频摇头。

这也是为什么眼动功能在车上还不能直接用于跟界面内容交互的原因,可能得等到脑机接口上车才有真正的眼动跟随,只不过那时候已经不再需要追踪眼睛看哪里了,而是直接获取意图去执行动作了。

不过呢,虽然现在的智能座舱没有真正的“看哪点哪”的功能,但有一个更有性价比的方案“可见即可说”,可以有效实现与眼动识别功能类似的效果。

眼动识别在大视角识别场景下有DMS(驾驶员监测系统)的应用,用来判断驾驶员是否有关注行驶路况。而像素级别的焦点反馈技术因为姿态的多变性暂时还没有得到实现。

而经常开车的朋友肯定都遇到过这样的场景:正操作车机界面找歌单的时候,绿灯亮了,结果只操作了一半,目光和手又要回归到专注驾驶的状态。要知道,语音识别功能在以前还不能够实现全功能的交互。这种场景下还真希望副驾驶有乘客能够帮忙点一下。

“可见即可说”就是为了满足这种场景的小助理,它通过获取屏幕上的文本内容,结合用户的语音文本识别来实现对应的页面切换或功能触发。

比如在音乐播放界面中帮忙点击每天名字都不一样的歌单,再比如在设置界面中切换到特定的页面。

“可见即可说”对比常规语音功能来说,免去了唤醒词,并且与用户的视觉内容做了高度对齐,因此执行命令的时候也不需要用“打开某某某”这样的语句,实现更高效率的界面操作。

“可见即可说”这个功能的出现,既让程序员和产品经理的关系得到缓和,更让驾驶的过程变得更加安全。